El Poder Judicial de Mendoza fijó pautas para la intervención policial, priorizando derechos humanos, uso proporcional de la fuerza y el diálogo en manifestaciones.

A diferencia de lo que muchos creen, la inteligencia artificial (IA) tiene más de un siglo de historia. Surgió en 1956 en el Dartmouth College, en Hanover (Estados Unidos), durante un curso de verano.

Opinión22/04/2024 Redacción CuyoNoticias

Redacción CuyoNoticias

El curso fue organizado por cuatro investigadores estadounidenses: John McCarthy, Marvin Minsky, Nathaniel Rochester y Claude Shannon. Sin embargo, pocos pensaron en los alcances que podría llegar a tener.

El curso fue organizado por cuatro investigadores estadounidenses: John McCarthy, Marvin Minsky, Nathaniel Rochester y Claude Shannon. Sin embargo, pocos pensaron en los alcances que podría llegar a tener.

Desde robótica, reconocimiento facial y automóviles autónomos hasta gestión de inventario, experiencias de compra personalizadas y chatbots, la reciente masificación del uso de la IA supone una revolución que está al mismo nivel de la irrupción de las computadoras, de Internet o de los dispositivos móviles y supone un cambio con la forma en la que las personas se vinculan con la información.

Los múltiples beneficios de su aplicación, tanto para los usuarios como para las grandes corporaciones, están a la vista de todos. La capacidad de las máquinas para usar algoritmos, aprender de los datos y utilizar los conocimientos emulando al cerebro humano ha adquirido una gran importancia en los últimos tiempos y cada vez son más los usos en los que se emplea. Sin embargo, al ser una tecnología tan potente en todos los sentidos, también conlleva una gran responsabilidad en cuanto a su aplicación y seguimiento.

El rol de las compañías expertas en tecnología es fundamental en ese sentido, a partir del diseño de políticas de uso responsable que permitan garantizar los derechos y las libertades de todas las personas que pudieran verse afectadas por su uso. También, a la hora de establecer las bases que rigen su aplicación en todos los proyectos que la incorporen.

La ética, la equidad y la transparencia son pilares fundamentales que no deben dejarse de lado. Los principios éticos recogidos por la Comisión Europea son una buena referencia para ello, con los que se pretende mejorar el bienestar individual y colectivo y deberían estar presentes en todos los proyectos que involucren IA. Estos principios son: el respeto a la autonomía humana y la garantía de que se realizará un control sobre los procesos de trabajo de los sistemas de IA para potenciar y complementar las aptitudes de las personas.

Otro de los principios es la prevención del daño, con el que se garantiza que los sistemas de IA no perjudicarán a nadie, ya que serán lo suficientemente seguros y robustos desde un punto de vista técnico. Asimismo, resaltan el principio de equidad para garantizar una distribución justa e igualitaria de sus beneficios y costos y la posibilidad de oponerse a las decisiones adoptadas por los sistemas de IA. Y, por último, destaca el principio de explicabilidad, que implica que todos los procesos de desarrollo de IA sean transparentes y se comuniquen de manera clara.

También se han pautado una serie de requisitos para garantizar que se trata de un sistema de Inteligencia Artificial Responsable, aplicables durante todo el ciclo de vida de estos procesos. En este sentido, debe activarse la supervisión humana para garantizar que los procesos sean seguros y se basen en una técnica robusta. Además, la gestión de los datos debe ser sólida para poder prevenir el daño a la privacidad, siendo un sistema transparente y que garantice la inclusión, la diversidad y la igualdad de acceso, además del bienestar ambiental y social. Por último, también será relevante la responsabilidad y rendición de cuentas sobre los sistemas de IA y sus resultados.

Los roles humanos son primordiales en ese uso responsable de la IA; para eso, las compañías también deben elaborar una metodología específica para aplicar esta política. En primer lugar, el responsable de proyecto expondrá el modelo de negocio y la finalidad de la solución presentada. Posteriormente, el Comité de Inteligencia Artificial supervisará y garantizará el cumplimiento de la solución de IA y definirá los requisitos que se van a evaluar. Contando con la aprobación del comité, el desarrollador de IA diseñará, implementará y probará la solución y, por último, el operador de Inteligencia Artificial ejecutará y supervisará la solución.

De esta manera, se podrá defender el propósito de respetar los valores éticos y morales y garantizar el cumplimiento de las normas, promoviendo la utilización de la tecnología mediante el desarrollo y la adquisición de soluciones de Inteligencia Artificial.

Nota de Mario Roberto Barrientos, gerente de Cumplimiento Normativo del Grupo Prosegur Argentina

El Poder Judicial de Mendoza fijó pautas para la intervención policial, priorizando derechos humanos, uso proporcional de la fuerza y el diálogo en manifestaciones.

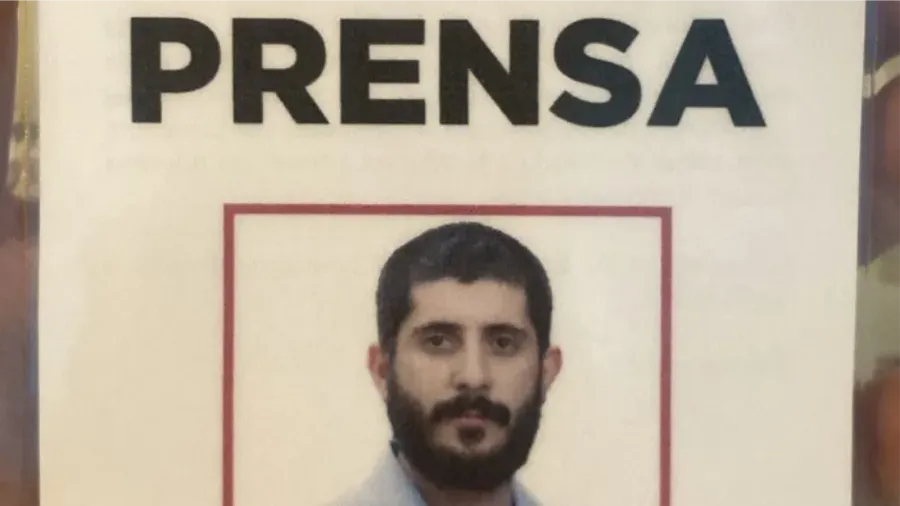

El Foro de Periodismo Argentino (FOPEA) condena detención del periodista Bautista Franco por parte de la policía mendocina mientras cubría una manifestación.

Desde el Partido Obrero en el Frente de Izquierda denunciamos que la media sanción de la Declaración de Impacto Ambiental de San Jorge y Malargüe Occidental no es un avance, sino un retroceso ambiental y social.

Mesa de Fraternidad de San Luis celebra el Día de la Tolerancia. Reafirman el compromiso de construir diálogo y paz social desde la diversidad de credos

Bodegas de Argentina acompaña la implementación del nuevo Digesto Normativo del Instituto Nacional de Vitivinicultura.

El abogado mendocino alertó por el fin del control estatal sobre las cuotas de colegios privados: “La educación será solo para ricos si el Estado se retira”.

Argentinos por la Educación advierte que la inversión sigue en niveles históricamente bajos. Los pliegos ya están disponibles para revisión y sugerencias.

Viajes internacionales cortos, experiencias auténticas y escapadas en solitario definen los hábitos de la Generación Z, según un informe de Airbnb.

Entre viñedos y la Cordillera, el exclusivo resort inaugura el verano 2026 ofreciendo glamps de lujo, gastronomía local y experiencias de bienestar.

Se sorteó el programa de partidos de la Primera Nacional, el Tomba y el Cruzado jugarán en zonas distintas pero habrá interzonal con partido y revancha.

Un automóvil Peugeot 408 impactó contra un árbol en la Ruta Provincial 171. Murieron el conductor y su acompañante, aún sin identificar.

El siniestro ocurrió al mediodía del 25 de diciembre en la ruta provincial 1, al norte de Juan Jorba. La víctima tenía 42 años y viajaba con su familia.